在當今數字驅動的世界中,數據已成為企業決策和運營的核心資源。為了最大化數據的價值,組織必須有效管理數據的生命周期,這通常涉及三個關鍵概念:數據治理、數據集成和數據處理。本文將對這三個概念進行全面解析。

一、數據治理

數據治理是一套框架和流程,旨在確保數據在整個組織中的質量、安全性、可用性和一致性。它涉及定義策略、標準、角色和責任,以管理數據資產。數據治理的目標包括:

- 數據質量管理:通過監控和修復數據錯誤,確保數據的準確性、完整性和可靠性。

- 數據安全與合規性:保護數據免受未授權訪問,并遵守相關法規(如GDPR或CCPA)。

- 數據所有權與問責制:明確數據所有者,確保數據使用符合業務目標。

- 元數據管理:記錄數據的來源、定義和關系,提高數據可理解性。

有效的數據治理有助于降低風險、提高決策質量,并支持數據驅動的文化。

二、數據集成

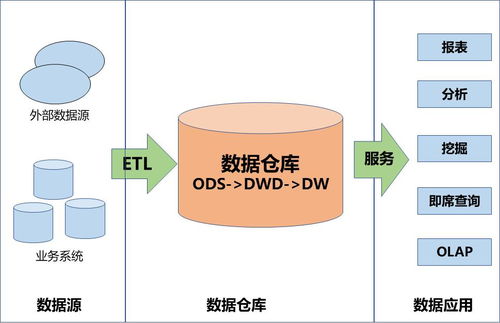

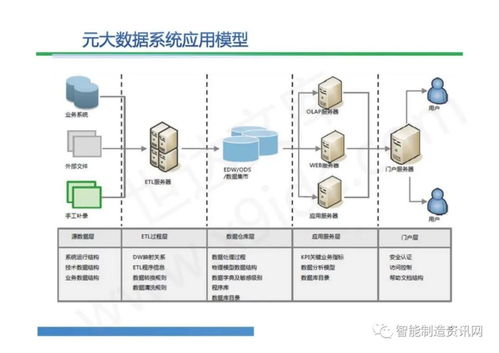

數據集成是指將來自不同來源(如數據庫、應用程序或外部系統)的數據合并到一個統一的視圖或存儲中,以提供一致、全面的信息。常見的數據集成方法包括:

- ETL(提取、轉換、加載):從源系統提取數據,進行清洗和轉換,然后加載到目標系統(如數據倉庫)。

- ELT(提取、加載、轉換):類似ETL,但轉換步驟在加載后執行,適用于大數據場景。

- 數據虛擬化:在不移動數據的情況下,提供統一的邏輯視圖,適合實時查詢。

- API集成:通過應用程序接口連接不同系統,實現數據共享。

數據集成的優勢包括消除數據孤島、提高數據可訪問性,并支持分析和報告。它也可能面臨數據格式不一致、延遲和安全性等挑戰。

三、數據處理

數據處理是指對原始數據進行操作,以提取有價值的信息或轉換為所需格式。它包括多個階段:

- 數據收集:從各種來源(如傳感器、日志或用戶輸入)獲取數據。

- 數據清洗:處理缺失值、重復項和錯誤,確保數據質量。

- 數據轉換:將數據標準化、聚合或豐富,以適應分析需求。

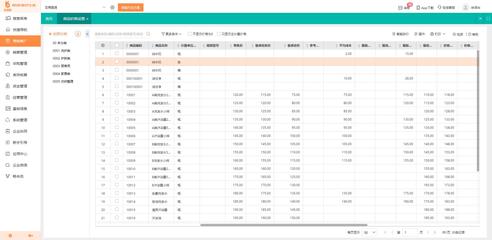

- 數據存儲:使用數據庫、數據湖或云存儲保存數據。

- 數據分析與可視化:應用統計方法或機器學習模型,生成見解并通過圖表展示。

數據處理可以分為批處理(處理大量歷史數據)和流處理(實時處理數據流)。現代技術如Hadoop、Spark和Kafka已極大地提升了處理效率。

總結

數據治理、數據集成和數據處理是數據管理生態系統的三大支柱。數據治理提供策略和規則,確保數據可靠和安全;數據集成打破數據孤島,實現信息統一;數據處理則從原始數據中提取價值。組織需要協調這些環節,以構建強大的數據基礎設施,從而推動創新和競爭優勢。隨著人工智能和物聯網的發展,這些概念將繼續演化,要求企業持續投資于數據能力建設。